15 października 2020 w magazynie The Guardian ukazał się długi, niezwykle ciekawy i trzeźwy artykuł, dotyczący zagrożeń ze strony AI i technologii AI stosowanej w wojsku. Artykuł nosi tytuł „Maszyny spuszczone by dokonać rzezi: niebezpieczny rozwój wojskowej sztucznej inteligencji” i stanowi przekrój przez dylematy, przed którymi stoją naukowcy, cywile i organizacje z całego świata. Poniżej umieszczam tłumaczenie tego artykułu, z własnymi dopiskami i przypisami. Zapraszam do lektury i przemyśleń.

Wideo jest wymowne. Dwóch groźnych mężczyzn stoi obok białej furgonetki na polu, trzymając w rękach piloty. Otwierają tylne drzwi furgonetki i rozbrzmiewa jęczący dźwięk dronów quadkopterów crescendo. Wciskają przełącznik, a drony wylatują jak nietoperze z jaskini. Za kilka sekund przechodzimy do sali wykładowej na uczelni. Zabójcze roboty wlewają się przez okna i otwory wentylacyjne. Uczniowie krzyczą z przerażenia, uwięzieni w środku, gdy drony atakują ze śmiercionośną siłą. Lekcja, jaką stara się przekazać film Slaughterbots, jest jasna: malutkie zabójcze roboty albo już są wśród nas, albo w niewielkiej odległości. Terroryści mogliby je łatwo rozmieścić. A istniejące mechanizmy obronne są słabe lub nie istnieją wcale.

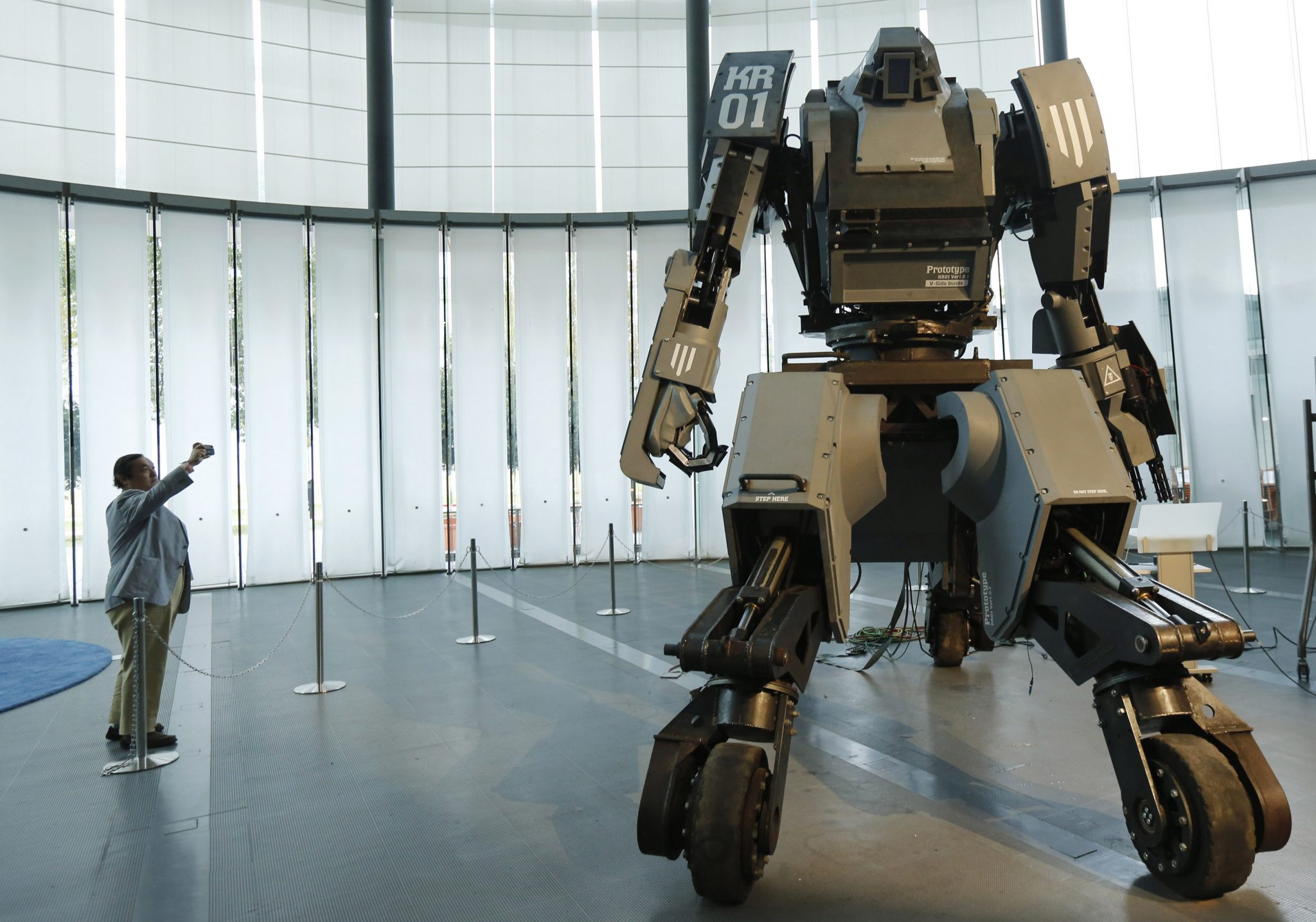

Niektórzy eksperci wojskowi twierdzą, że film „Slaughterbots”, stworzony przez Future of Life Institute, organizację badającą egzystencjalne zagrożenia dla ludzkości (wg mnie, jest to organizacja buforowa, sądząc po jej członkach i opisie ich działalności; nawet nie starają się specjalnie ukrywać swoich technokratycznych i transhumanistycznych zainteresowań, a „przyszłość życia” w opisach działalności poszczególnych członków i sponsorów wygląda raczej jako zniszczenie życia biologicznego i zastąpienie go życiem syntetycznym; do tej organizacji jeszcze wrócimy – przyp. U.K.) – wywołuje sensację, podsycając strach tam, gdzie wymagana jest spokojna refleksja. Ale jeśli chodzi o przyszłość wojny, granica między science fiction a faktami jest często niewyraźna. Siły powietrzne USA przewidziały przyszłość, w której „zespoły Swat wyślą mechaniczne owady wyposażone w kamery wideo, aby wkradły się do budynku podczas akcji odbijania zakładników”. Jeden z „współpracujących mikrosystemów” wypuścił już Octoroach, „niezwykle małego robota z kamerą i nadajnikiem radiowym, który może pokonać do 100 metrów nad ziemią”. To tylko jedna z wielu broni „biomimetycznych”, czyli imitujących naturę (Nicanor Perlas, Filipińczyk zajmujący się systemami ludzkimi, sztuczną inteligencją i antropozofią, w swojej książce „Humanity’s Last Stand” wskazuje na główną strategię sztucznej inteligencji w jej wysiłku przejęcia rzeczywistości analogowej, która polega na zastępowaniu[i]– przyp. U.K.)

Kto wie, ile innych stworzeń jest obecnie wzorami dla awangardowych teoretyków wojskowości. Niedawna powieść PW Singera i Augusta Cole’a, której akcja rozgrywa się w niedalekiej przyszłości, w której Stany Zjednoczone toczą wojnę z Chinami i Rosją, przedstawia kalejdoskopową wizję autonomicznych dronów, laserów i uprowadzonych satelitów. Książki nie można uznać za fantazję techno-wojskową: zawiera setki przypisów dokumentujących rozwój poszczególnych sprzętów i oprogramowania.

Postępy w modelowaniu robotów zabójców są równie niepokojące. Rosyjska opowieść science fiction z lat 60. „Kraby na wyspie” opisuje rodzaj Igrzysk Śmierci dla SI, w których roboty walczą ze sobą o zasoby. Przegrani są usuwani, a zwycięzcy rozrastają się stają się najlepszymi maszynami do zabijania. Kiedy czołowy informatyk naszych czasów, Pedro Domingos (autor książki „Naczelny Algorytm”, wyd. Helion – przyp. U.K.) wspomniał o podobnym scenariuszu amerykańskiej Agencji Zaawansowanych Projektów Badawczych Obrony (DARPA), nazywając go „parkiem jurajskim robotów”, jeden z tamtejszych liderów nazwał to „wykonalnym” scenariuszem. Nie potrzeba wiele refleksji, aby zdać sobie sprawę, że taki eksperyment może wymknąć się spod kontroli. Koszt jest główną przeszkodą w eksperymentowaniu z takimi potencjalnie niszczycielskimi maszynami. Modelowanie oprogramowania może wyeliminować tę barierę, pozwalając wirtualnym symulacjom zainspirować przyszłe inwestycje wojskowe.

W przeszłości państwa narodowe gromadziły się i obradowały, aby zakazać szczególnie makabrycznej lub przerażającej nowej broni. W połowie XX wieku międzynarodowe konwencje zakazały broni biologicznej i chemicznej. Społeczność narodów (zgromadzona wokół Czerwonego Krzyża- przyp. U.K.) również zakazała używania oślepiającej technologii laserowej (więcej). Solidna sieć organizacji pozarządowych z powodzeniem wezwała ONZ (z powodzeniem wezwała do zwołania spotkania, jednak uzgodnienie jakichkolwiek regulacji w tej sprawie nadal nie miało miejsca – przyp. U.K.) by zwołano państwa członkowskie, by te uzgodniły podobny zakaz używania zabójczych robotów i innej broni, która może działać samodzielnie, bez bezpośredniej kontroli człowieka, w celu zniszczenia celu (zwanej śmiercionośnymi autonomicznymi systemami uzbrojenia – LAWS). I chociaż toczyła się debata na temat definicji takiej technologii, wszyscy możemy sobie wyobrazić szczególnie przerażające rodzaje broni, których żadne państwa nigdy nie powinny zgodzić się wytwarzać i rozmieszczać. Dron, który stopniowo podgrzewa żołnierzy wroga na śmierć, naruszyłby międzynarodowe konwencje przeciwko torturom (analiza tej broni) broń dźwiękowa zaprojektowana do niszczenia słuchu lub równowagi wroga powinna zostać potraktowana jednakowo. Kraj, który projektuje i używa takiej broni, powinien zostać wygnany ze społeczności międzynarodowej.

Możemy prawdopodobnie zgodzić się, że ostracyzm i bardziej surowa kara należą się projektantom i użytkownikom robotów-zabójców. Sam pomysł maszyny wypuszczonej w celu dokonania rzezi jest mrożący. A jednak wygląda na to się, że niektóre z największych sił zbrojnych świata idą w kierunku opracowania takiej broni, kierując się logiką odstraszania: boją się zmiażdżenia przez sztuczną inteligencję rywali jeśli nie będą w stanie wyzwolić równie potężnej siły. Klucz do rozwiązania tego trudnego wyścigu zbrojeń może leżeć nie tyle w traktatach globalnych, ile w ostrożnym przemyśleniu, do czego można wykorzystać bojową sztuczną inteligencję. Gdy „wojna wraca do domu” (chodzi o to, że po wywołanych wojnach w Iraku i Afganistanie, Stany Zjednoczone znacznie zintensyfikowały nadzór i inwigilację we własnym kraju przy użyciu technologii – przyp. U.K.), rozmieszczenie sił wojskowych w krajach takich jak USA i Chiny jest surowym ostrzeżeniem dla ich obywateli: wszelkie technologie kontroli i niszczenia, które rząd kupuje teraz do użytku za granicą, mogą być w przyszłości wykorzystane przeciwko tobie.

Czy są zabójcze roboty są tak przerażające jak broń biologiczna? Niekoniecznie, argumentują niektórzy teoretycy wojskowi i informatycy. Według Michaela Schmitta z Akademii Marynarki Wojennej Stanów Zjednoczonych, roboty wojskowe mogą pilnować przestworzy, by rzeź, taka jak zabójstwo Kurdów i Arabów Marsh przez Saddama Husseina, nie powtórzyła się. Ronald Arkin z Georgia Institute of Technology uważa, że autonomiczne systemy uzbrojenia mogą „zredukować nieludzki stosunek człowieka do człowieka za pomocą technologii”, ponieważ robot nie będzie poddawał się zbyt ludzkim napadom gniewu, sadyzmu czy okrucieństwa. Proponuje wyrwanie ludzi z pętli decyzji kierowniczych, jednocześnie kodując ograniczenia etyczne w robotach. Arkin opracował również klasyfikację docelową, aby chronić miejsca takie jak szpitale i szkoły.

W teorii preferowanie kontrolowanej przemocy maszynowej zamiast nieprzewidywalnej przemocy ludzkiej może wydawać się rozsądne. Masakry, które mają miejsce podczas wojny, często wydają się być zakorzenione w irracjonalnych emocjach. Jednak często najbardziej potępiamy nie przemoc popełnioną w ogniu namiętności, lecz mordercę z premedytacją, który chłodno zaplanował swój atak. Historia działań wojennych dostarcza wielu przykładów starannie zaplanowanych masakr. I z pewnością każdy system broni robotycznej może być zaprojektowany z jakąś funkcją nadrzędną, która byłaby kontrolowana przez ludzkich operatorów, podlegająca wszystkim ludzkim pasjom i irracjonalności.

Każda próba zakodowania prawa i etyki w robotach-zabójcach rodzi ogromne trudności praktyczne. Profesor informatyki Noel Sharkey argumentował, że niemożliwe jest zaprogramowanie wojownika-robota tak, aby reagował na nieskończoną gamę sytuacji, które mogą zaistnieć w ogniu konfliktu. Podobnie jak autonomiczny samochód, który staje się bezradny z powodu śniegu zakłócającego działanie jego czujników, autonomiczny system uzbrojenia w sytuacji wojny jest niebezpieczny.

Większość żołnierzy mogłaby zaświadczyć, że codzienne doświadczenie wojny to długie okresy nudy, przerywane nagłymi, przerażającymi okresami nieporządku. Ujednolicenie opisów takich incydentów w celu kierowania bronią robotyczną może być wręcz niemożliwe. Uczenie maszynowe działa najlepiej, gdy istnieje ogromny zbiór danych z jasno zrozumiałymi przykładami dobra i zła. Na przykład, firmy obsługujące karty kredytowe ulepszyły mechanizmy wykrywania oszustw dzięki ciągłym analizom setek milionów transakcji, w których fałszywe negatywy i fałszywe alarmy są łatwo oznaczane z niemal 100% dokładnością. Czy udałoby się „zebrać dane” na temat doświadczeń żołnierzy w Iraku, decydując, czy strzelać do niejednoznacznie okreslonych wrogów? Nawet gdyby tak było, jak istotny byłby taki zestaw danych dla okupacji, powiedzmy, Sudanu lub Jemenu (dwóch z wielu krajów, w których jest obecna jakaś armia USA)?

Biorąc pod uwagę te trudności, trudno oprzeć się wnioskowi, że idea etycznych robotów do zabijania jest nierealna i jest zbyt prawdopodobne, że będzie wspierać niebezpieczne fantazje o wojnach z przyciskami w dłoni i niewinnych rzeziach.

Międzynarodowe prawo humanitarne, które reguluje konflikty zbrojne, stawia przed twórcami autonomicznej broni jeszcze większe wyzwania. Kluczową etyczną zasadą prowadzenia wojny jest rozróżnianie: wymaganie od atakujących rozróżnienia między żołnierzami a cywilami. Jednak w ostatnich dziesięcioleciach coraz bardziej powszechna staje się wojna partyzancka lub rebeliancka, a bojownicy w takich sytuacjach rzadko noszą mundury, co utrudnia ich odróżnienie od cywilów. Biorąc pod uwagę trudności, z jakimi borykają się ludzcy żołnierze w tym zakresie, łatwo jest dostrzec jeszcze większe ryzyko, jakie stwarzają zrobotyzowane systemy broni.

Zwolennicy takiej broni twierdzą, że zdolności maszyn do rozróżniania stale się poprawiają. Nawet jeśli tak jest, założenie, że dowódcy wykorzystają te osiągnięcia technologiczne, aby opracować sprawiedliwe zasady rozróżniania w zgiełku i zamieszaniu wojennym, jest ogromnym skokiem w logice. Jak napisał francuski myśliciel Grégoire Chamayou, kategoria „walczącego” (uzasadnionego celu) czasami „rozmywała się w taki sposób, że rozciągała się na jakąkolwiek formę członkostwa, współpracy z lub domniemania sympatii dla niektórych bojowników jakiejś organizacja”.

Zasada rozróżnienia między żołnierzami a cywilami jest tylko jednym z wielu międzynarodowych praw regulujących działania wojenne. Istnieje również zasada, że operacje wojskowe muszą być „proporcjonalne” – należy zachować równowagę między potencjalną szkodą dla ludności cywilnej a korzyścią militarną, jaka może wyniknąć z działania. Siły powietrzne USA opisały kwestię proporcjonalności jako „z natury subiektywną determinację, która będzie rozstrzygana indywidualnie dla każdego przypadku”. Bez względu na to, jak dobrze technologia monitoruje, wykrywa i neutralizuje zagrożenia, nie ma dowodów na to, że może angażować się w rodzaj subtelnego i elastycznego rozumowania niezbędnego do stosowania nawet nieco niejednoznacznych praw lub norm.

Nawet gdybyśmy założyli, że postęp technologiczny może zmniejszyć użycie śmiercionośnej siły w działaniach wojennych, czy to zawsze byłoby dobre? Analizując rosnący wpływ zasad praw człowieka na konflikty, historyk Samuel Moyn zauważa paradoks: wojna stała się „bardziej humanitarna i trudniejsza do zakończenia”. Dla najeźdźców i ich polityków roboty oszczędzają zmartwień o ofiary, które normalnie podsycają opozycję w kraju. Drony- żelazna pięść w aksamitnej rękawicy zaawansowanej technologii, mogą dokonać tylko tyle inwigilacji, by uspokoić okupowanych, unikając jednocześnie niszczycielskiego rozlewu krwi, który sprowokowałby rewolucję lub międzynarodową interwencję.

W tej zrobotyzowanej wizji „humanitarnej dominacji” wojna coraz bardziej przypominałaby eksterytorialną akcję policji. Wrogowie zostaliby zastąpieni przez podejrzanych, którzy byliby zatrzymywani mechanicznie zamiast używać śmiercionośnej siły. Jakkolwiek pomocne może się to wydawać, wg Moyn’a, ogromna różnica sił leżąca u podstaw technologicznej okupacji krajów i terytoriów, nie jest właściwą podstawą dla prawowitego porządku międzynarodowego.

Chamayou jest również sceptyczny. W swojej wnikliwej książce „Drone Theory” przypomina czytelnikom o rzezi 10 000 Sudańczyków w 1898 r. dokonanej przez armię anglo-egipską uzbrojoną w karabiny maszynowe, która sama poniosła tylko 48 ofiar. Chamayou nazywa drona „bronią amnestycznej postkolonialnej przemocy”. Ma również wątpliwość, czy postępy w robotyce rzeczywiście zaowocują taką precyzją, jaką obiecują fani zabójczych robotów. Cywile są rutynowo zabijani przez wojskowe drony pilotowane przez ludzi. Usunięcie tej możliwości może wiązać się z równie ponurą przyszłością, w której systemy komputerowe będą prowadzić tak intensywny nadzór nad populacjami, że będą w stanie ocenić zagrożenie stwarzane przez każdą osobę (i odpowiednio je zlikwidować lub oszczędzić).

Zwolennicy dronów twierdzą, że ta broń jest kluczem do bardziej humanitarnej i opartej na lepszym rozróżnianiu wojny. Ale dla Chamayou „wykluczając możliwość walki, dron niszczy możliwość jakiegokolwiek wyraźnego rozróżnienia między walczącymi i niewalczącymi”. Twierdzenie Chamayou może wydawać się hiperbolą, ale weźmy pod uwagę sytuację w Jemenie lub w Pakistanie: czy rzeczywiście istnieje poważny opór, gdzie „bojownicy” mogą oprzeć się strumieniowi setek lub tysięcy bezzałogowych statków powietrznych patrolujących ich niebo? Takie kontrolowane środowisko prowadzi do niepokojącej fuzji wojny i działań policyjnych, pozbawionych ograniczeń i zabezpieczeń, ustanowionych by przynajmniej spróbować wprowadzić odpowiedzialność w te działania.

Jak światowi przywódcy powinni zareagować na perspektywę tych niebezpiecznych nowych technologii zbrojeniowych? Jedną z opcji jest wspólne dążenie do całkowitego zakazania pewnych metod zabijania. Aby zrozumieć, czy takie międzynarodowe porozumienia o kontroli zbrojeń mogą zadziałać, warto spojrzeć w przeszłość. Mina przeciwpiechotna, zaprojektowana do zabijania lub okaleczania każdego, kto nadepnął na nią lub był w jej pobliżu, była wczesną bronią automatyczną. Przerażało to bojowników pierwszej wojny światowej. Tanie i łatwe w dystrybucji miny nadal były wykorzystywane w mniejszych konfliktach na całym świecie. Do 1994 roku żołnierze rozłożyli 100 mln min przeciwpiechotnych w 62 krajach. Miny te nadal niszczyły i zastraszały ludność przez lata po zakończeniu działań wojennych. Poszkodowani często tracili co najmniej jedną nogę, czasami dwie, a także doznawali ran szarpanych, infekcji i urazów. W 1994 roku 1 na 236 Kambodżan straciło co najmniej jedną kończynę w wyniku eksplozji tych min.

W połowie lat 90. narastał międzynarodowy konsensus, że miny lądowe powinny być zakazane. Międzynarodowa kampania na rzecz zakazu min przeciwpiechotnych wywierała presję na rządy na całym świecie, by je potępiły. Mina nie jest tak zabójcza jak wiele innych broni, ale w przeciwieństwie do innych zastosowań siły może okaleczać i zabijać cywilów jeszcze długo po zakończeniu wojny. Do 1997 r., kiedy kampania zakazująca min przeciwpiechotnych zdobyła pokojową nagrodę Nobla, dziesiątki krajów podpisały z mocą wiążącą międzynarodowy traktat, zobowiązując się nie produkować, nie składować ani nie rozmieszczać takich min.

Stany Zjednoczone odmówiły i do dziś nie podpisały konwencji o broni przeciwminowej. W czasie negocjacji, negocjatorzy ze Stanów Zjednoczonych i Wielkiej Brytanii nalegali, aby prawdziwym rozwiązaniem problemu min lądowych było zapewnienie, że przyszłe miny zostaną automatycznie wyłączone po określonym czasie lub będą miały pewne możliwości zdalnego sterowania. Oznaczałoby to, że urządzenie można wyłączyć zdalnie po zakończeniu działań wojennych. Oczywiście, można je było także ponownie włączyć.

Technologiczne rozwiązanie USA znalazło niewielu zwolenników. Do 1998 r. dziesiątki krajów podpisały traktat o zakazie min. Corocznie w latach 1998-2010 dołączały kolejne kraje, w tym główne mocarstwa, takie jak Chiny. Podczas gdy administracja Obamy podjęła pewne ważne kroki w kierunku ograniczenia min, sekretarz obrony Trumpa cofnął je. Ta odwrotność to tylko jeden z aspektów wojowniczego nacjonalizmu, który prawdopodobnie przyspieszy automatyzację działań wojennych.

Zamiast zakazów zabójczych robotów, amerykański establishment wojskowy woli regulacje. Obawy związane z awariami, usterkami lub innymi niezamierzonymi konsekwencjami broni automatycznej doprowadziły do wyważonego dyskursu na temat reformy robotyki wojskowej. Na przykład, PW Singer z New America Foundation przyzwala robotowi na „autonomiczne użycie tylko nieśmiercionośnej broni”. Tak więc autonomiczny dron mógłby patrolować pustynię i, powiedzmy, ogłuszyć walczącego lub owinąć go siecią, ale „decyzja o zabiciu” byłaby pozostawiona samym ludziom. Zgodnie z tą zasadą, nawet gdyby walczący próbował zniszczyć drona, dron nie mógłby go zabić.

Takie zasady przeniosłyby wojnę w działania mające na celu utrzymywanie pokoju i wreszcie do formy działań policyjnych. Czas między podjęciem decyzji o pojmaniu a zabiciem może umożliwić odpowiedni proces niezbędny do oceny winy i ustalenia kary. Singer podkreśla również znaczenie odpowiedzialności, argumentując, że „jeśli programista przez pomyłkę wysadzi w powietrze całą wioskę, powinien zostać pociągnięty do odpowiedzialności karnej”.

Podczas gdy niektórzy teoretycy wojskowi chcą kodować roboty zgodnie z etyką algorytmiczną, Singer mądrze opiera się na naszym wielowiekowym doświadczeniu w regulowaniu osób. Aby zapewnić odpowiedzialność za wdrażanie „algorytmów wojennych”, siły zbrojne musiałyby zapewnić identyfikowalność robotów i algorytmicznych agentów i identyfikację z ich twórcami. W kontekście krajowym, uczeni zaproponowali „tablicę rejestracyjną dla dronów”, aby powiązać wszelkie lekkomyślne lub niedbałe działania z właścicielem lub kontrolerem drona. Jest bardzo sensowne, że podobna zasada – coś w rodzaju „Robot zawsze musi wskazywać tożsamość swojego twórcy, kontrolera lub właściciela” – powinna służyć jako podstawowa zasada prowadzenia wojny, a jej naruszenie podlega surowym sankcjom.

Ale jak naprawdę jest prawdopodobne, że programiści zabójczych robotów zostaliby faktycznie ukarani? W 2015 roku wojsko USA zbombardowało szpital w Afganistanie, zabijając 22 osoby. Już w trakcie bombardowania personel szpitala gorączkowo dzwonił do swoich kontaktów w armii amerykańskiej, błagając o zaprzestanie. Istoty ludzkie są bezpośrednio odpowiedzialne za ataki dronów na szpitale, szkoły, przyjęcia weselne i inne nieodpowiednie cele, bez proporcjonalnych konsekwencji. „Mgła wojny” usprawiedliwia wszelkie zaniedbania. Nie wydaje się prawdopodobne, aby krajowe lub międzynarodowe systemy prawne nakładały większą odpowiedzialność na programistów, którzy dokonują podobnej rzezi.

Broń zawsze była wielkim biznesem, a wyścig zbrojeń sztucznej inteligencji obiecuje zyski osobom znającym się na technologii i dobrze skomunikowanym politycznie. Doradztwo przeciwko wyścigom zbrojeń wydaje się nierealne. W końcu narody wkładają ogromne zasoby w wojskowe zastosowania sztucznej inteligencji, a wielu obywateli tego nie wie lub nie obchodzi ich to. Jednak ta spokojna postawa ludzi może się wkrótce zmienić, gdy wzrasta wykorzystanie inwigilacji sztucznej inteligencji w kraju, a technologia ta jest coraz częściej utożsamiana z podejrzanymi aparatami kontroli, a nie demokratycznie odpowiedzialnymi władzami lokalnymi.

Wojskowa i inwigilacyjna sztuczna inteligencja nie jest używana tylko, a nawet przede wszystkim, na zewnętrznych wrogach. Jest wykorzystywana, by identyfikować i zwalczać wrogów w środku. Chociaż przez prawie dwie dekady w Stanach Zjednoczonych nie pojawiło się nic podobnego do ataków z 11 września, wewnętrzne siły bezpieczeństwa po cichu zwróciły narzędzia antyterrorystyczne przeciwko przestępcom, oszustom ubezpieczeniowym, a nawet protestującym. W Chinach rząd zaalarmował groźbą „muzułmańskiego terroryzmu”, aby wyłapać znaczną część Ujgurów do obozów reedukacyjnych i zastraszyć innych poprzez ciągłe inspekcje telefoniczne i profilowanie ryzyka (więcej na ten temat w książce Cyrusa A. Parsy „AI: Zagrożenie dla Ludzkości”, która już wkrótce ukaże się w języku polskim i będzie dostępna w wersji elektronicznej na platformie Amazon – przyp. U.K.). Nikogo nie powinno już dziwić, że jakiś chiński sprzęt zasila amerykański aparat wywiadowczy, podczas gdy ogromne amerykańskie firmy technologiczne są kooptowane przez chiński rząd do równoległych projektów inwigilacji.

Rozwój wykorzystania sztucznej inteligencji w wojsku, policji, więzieniach i służbach bezpieczeństwa jest nie tyle rywalizacją między wielkimi mocarstwami, co lukratywnym globalnym projektem elit korporacyjnych i rządowych, mającym na celu utrzymanie kontroli nad niespokojnymi populacjami w kraju i za granicą. Wypróbowane w odległych bitwach i okupacjach metody wojskowe mają tendencję do znajdowania drogi powrotnej na front. Najpierw są wysyłane przeciwko niepopularnym lub stosunkowo bezsilnym mniejszościom, a następnie rozprzestrzeniają się na inne grupy. Urzędnicy Departamentu Bezpieczeństwa Wewnętrznego USA podarowali lokalnym wydziałom policji czołgi i zbroje. Szeryfowie będą jeszcze bardziej entuzjastycznie nastawieni do kierowania i oceny zagrożeń opartych na sztucznej inteligencji. Należy jednak pamiętać, że istnieje wiele sposobów rozwiązywania problemów społecznych. Nie wszystkie wymagają stałego nadzoru połączonego ze zmechanizowaną groźbą użycia siły. W istocie, może to być najmniej skuteczny sposób zapewnienia bezpieczeństwa na szczeblu krajowym lub międzynarodowym. Drony umożliwiły USA utrzymanie obecności w różnych strefach okupowanych znacznie dłużej, niż zrobiłaby to armia. Stała obecność robota-strażnika, który jest w stanie zaalarmować żołnierzy o każdym groźnym zachowaniu, jest formą ucisku. Amerykańskie siły obronne mogą twierdzić, że zagrożenia ze strony ludności Iraku i Pakistanu są wystarczająco groźne, by uzasadniać stałą czujność, ale ignorują fakt, że takie autorytarne działania mogą wywołać gniew, który potem chcą tłumić.

Obecnie kompleks militarno-przemysłowy przyspiesza w kierunku rozwoju rojów dronów, które działają niezależnie od ludzi, rzekomo dlatego, że tylko maszyny będą wystarczająco szybkie, aby przewidzieć przeciwne strategie wroga. Jest to samospełniająca się przepowiednia, mająca na celu pobudzenie wroga do rozwoju tej samej technologii, która rzekomo usprawiedliwia militaryzację algorytmów. Aby wyrwać się z tej autodestrukcyjnej pętli, musimy zakwestionować cały reformistyczny dyskurs nadania etyki robotom wojskowym. Zamiast marginalnych ulepszeń ścieżki do rywalizacji w zdolnościach bojowych potrzebujemy innej ścieżki – do współpracy i pokoju, jakkolwiek kruche i trudne może być jego osiągnięcie.

W swojej książce „Jak wszystko stało się wojną, a wojsko stało się wszystkim”, była urzędniczka Pentagonu, Rosa Brooks, opisuje rosnącą świadomość wśród amerykańskich ekspertów ds. Obrony, że rozwój, zarządzanie i pomoc humanitarna są tak samo ważne dla bezpieczeństwa jak projekcja siły, jeśli nie bardziej. Świat z bardziej realnymi zasobami ma mniej powodów do prowadzenia wojen o sumie zerowej (…)

Aby ten bardziej ekspansywny i ludzki sposób myślenia zwyciężył, jego zwolennicy muszą wygrać w swoich krajach walkę o idee dotyczące właściwej roli rządu i paradoksów bezpieczeństwa. Muszą odwrócić cele polityczne od dominacji za granicą i skierować się ku zaspokajaniu ludzkich potrzeb w kraju. Obserwując rozwój amerykańskiego państwa bezpieczeństwa narodowego, które nazywa „imperium drapieżników”, autor Ian GR Shaw pyta: „Czy nie widzimy wzrostu znaczenia kontroli nad współczuciem, bezpieczeństwa nad wsparciem, kapitału nad opieką i wojny nad dobrobytem?” Zatrzymanie tej tendencji powinno być głównym celem współczesnej polityki dotyczącej sztucznej inteligencji i robotyki.

- Na podstawie książki „New Laws of Robotics: Defending Human Expertise in the Age of AI”, Frank Pasquale, która zostanie opublikowana przez Harvard University Press 27 października

[i] Zastępowanie: metoda pracy Zła w świecie; Nicanor Perlas pisze w swojej książce: ”Ponieważ nieuniknionym jest, że stale będziemy otaczani przez technologię, ważnym jest, by zrozumieć jej wewnętrzną logikę. Gdy zrozumiemy tę wewnętrzną logikę, będziemy mogli zauważyć wyższą prawdę, która leży ukryta za ślepą, niszczycielską siłą technologii. Technologia skrywa ważne sekrety dotyczące procesu świata”. Dalej Perlas wskazuje na konkretne techniki, których używa Zło: ”Zło osłabia intencje bogów, którzy troszczą się i prowadzą ludzkość. Zło bardzo często robi to za pomocą zastępowania, zniekształcania wyższej i większej prawdy, która chce się urodzić duchowo i rozwinąć się w świecie- zastępuje ją czymś innym. Nie, technologia nie jest neutralna. Ma swoją wewnętrzną logikę. A logiką tą jest zastępowanie. Ostatecznie, chce totalnie zastąpić prawdziwego człowieka jego cyfrową wersją, a inną istotę wstawić w miejsce Chrystusa, który stoi na straży i opiekuje się prawdziwym człowiekiem.” Dalej, Perlas opisuje szczegółowo ścieżki działania Zła i jego technik zastępowania w rzeczywistości idei oraz wewnętrzną logikę technologii, gdzie, przykładowo, wirtualna rzeczywistość zostaje wprowadzona w miejsce aktywnej imaginacji. Nicanor Perlas, „Humanity’s Last Stand. The Challenge of Artificial Intelligence. A Spiritual-Scientific Response”, Temple Lodge 2018 (przyp. – U.K.)

Przetłumaczyła, przypisami opatrzyła i skomentowała: Urszula Klimko

Bardzo ciekawy blog, rzeczowy i wyważony. Od dzisiaj zaglądam regularnie. Pozdrowienia 🙂

Wspaniały blog wiele przydatnych informacji zawartych w poszczególnych postach, Dzięki Ci za to serdeczne, zapraszam także do siebie…

Cecha talentu jest niemoznosc pisania na zamowienie… Poza tym to Zgadzam sie z Toba w 100 i popieram w/w poglady w soposb preSubiektywny 🙂 E. Zegadlowicz.